==河海大学网络与安全实验室==

微信搜索:Hohai_Network

联系QQ:1084561742

责任编辑:何宇

2023.04.24-2023.04.30

简介

GUYUSHIJIE

标题: USV Formation and Path-Following Control via Deep Reinforcement Learning With Random Braking

期刊: IEEE Transactions on Neural Networks and Learning Systems, vol. 32, no. 12, pp. 5468-5478, Dec. 2021.

作者: Yujiao Zhao, Yong Ma, and Songlin Hu.

分享人: 河海大学——侯云

研究背景

GUYUSHIJIE

在过去的十年中,无人水面舰艇(USV)在很多应用领域取得了成就。为了完成艰巨的任务,通常需要多个欠驱动的USV共同完成任务,包括搜索和救援、侦察、数据收集等。对于多个欠驱动的USV来说,首要问题是路径跟踪问题。路径跟踪是USV控制领域中的一个基本问题。USV编队路径跟踪的主要目的是确保USV保持一定的编队,并在预定路径上导航。在此基础上,本文设计了一种有效的多个欠驱动USV编队路径跟踪方法,采用改进的深度强化学习与随机制动机制(DRLRB)解决了欠驱动无人表面舰艇(USVs)编队路径跟踪问题。并通过实验仿真验证了本文算法的有效性和优越性。

关键技术

GUYUSHIJIE

本文通过改进的随机制动深度强化学习 (DRLRB) 解决欠驱动无人水面舰艇 (USV) 编队的路径跟踪问题。构建基于深度强化学习(DRL)的编队控制模型,促使USV编队预设编队。具体而言,从与给定编队相关的每个USV的速度和误差距离的角度设计了一个有效的奖励函数,然后制定了一种新颖的随机制动机制,以防止决策网络的训练陷入局部最优未能达到培训目标。随后,针对USV编队问题开发了基于虚拟领导者的路径跟随制导系统。其中,借助DRRLB,即使在某些 USV 偏离编队时,本文提出的系统也可以自动灵活地调整编队。

本文的创新和贡献如下:

1) 基于DDPG引入了一种叫做DRL随机制动(DRLRB)的路径跟踪策略,以解决多个USV编队路径跟踪问题;

2) 本文提出的方法可以应对USV的故障和其他紧急情况,USV可以动态退出编队;

3) 为DDPG的训练设计了一种新的随机制动机制,并在编队保持和路径跟踪方面具有良好的性能。最后,仿真结果验证了本文的欠驱动的USV编队路径跟随方法DRLRB的有效性。

算法介绍

GUYUSHIJIE

A.问题建模

(1)USV运动学模型

图1 USV运动学模型

上图表示USV的运动学模型,文中使用的是一个三自由度的USV运动学模型,不考虑USV的横滚运动。其中,phi_ci表示USV的航向角,J是旋转矩阵,M是惯性矩阵,C是科里奥利矩阵,D是阻力,gi是未建模动力学。

(2)AUV编队路径追踪

如图2所示,pc是虚拟领导者的实际位置,pv是虚拟领导者的期望位置,pp是pc在规定好的路线上的投影。虚拟领导者被引入以校准编队中每个USV的参考位置,其位置代表编队的中心位置。对于如何保持编队,算法已经预先设置了编队形状,比如这里设置好这里是三角形的编队,那么AUV的期望位置就是以pc为中心的三角形的三个顶点。本文需要做的就是减少实际位置与期望位置之间的误差。下图中pv是是虚拟领导者的期望位置,pc是虚拟领导者的实际位置,p_cm是USVm的期望位置。P_vm 是USVm的实际位置。

图2 USV合作示意图

图3 USV编队的路径跟踪策略

如图3所示,USVm的期望位置可以由虚拟领导者的期望位置计算出来,如下所示:

本文的优化目标为:

其中,ef是计算智能体之间的平均误差,ed是计算虚拟领导者实际位置与其在路径上投影的误差。lambda是pv和pp间的一个距离,如下所示:

B.USV编队路径跟踪控制模型DRLRB

(1)USV路径追踪的DRL结构

图4为基于DDPG的USV编队的路径跟踪控制模型。路径跟踪模型是一个与环境迭代交互的过程。根据对环境的状态观察,USV可以做出合理的决定。通过结合任务目标目标和状态观察,可以评估多个欠驱动USV编队路径跟踪模型的动作选择。然后,根据评价值,可以得到欠驱动USV编队路径跟踪模型。最后,该模型将对相应的更新环境执行所选的动作,并重新获得观测状态,直到路径跟踪模型可以选择预期的动作。最终,该模型可以学会为多个USV做出理想的控制决策,以形成编队和路径追踪。

图4 基于DDPG的USV编队径跟踪控制模型

图5 环境探索和训练数据的收集系统

如图5所示,当涉及到决策网络时,多个USV可以作为一个编队进行训练。在训练决策网络时,环境由上述USV共同探索。由于各个USV初始状态不同,共同探索可以使得经验的重复率在本质上可以降低。可以看出,通过使用同一个决策网络,可以将多个USV训练在一起,从而保证了多个USV在编队中的行为一致性。

(2)状态表示和状态空间

USV的状态空间:在探索了多个未驱动的usv编队路径跟踪任务后,可以分为两个周期,包括多个未驱动的USV编队周期和路径跟踪一段时间关于USV编队时期,影响其速度和标准,包括每个USV的状态,以及USV、虚拟领导者和其他USV之间的关系,usv的状态以其位置(xci、yci)、航向phi_ci和速度νi(ui、vi、ri)来表征。虚拟领导者的位置(xv,yv)对于计算预期是必不可少的USV的位置。ef表示USV编队的队形误差。在路径跟踪期间,USV编队与预设路径之间的关系ed来表征。因此,N个USV的观测状态如下所示:

USV的动作空间为:

其中,Tau_ui表示推力输入,Tau_ri 表示方向舵输入.

(3)奖励函数

通过使用奖励函数,参考USV编队任务,USV可以快速导航到它们相应的参考坐标点。敦促USV迅速行动以确定的队形形成,USV的速度体现在奖励函数的设计中。在奖励函数中,当朝向参考点航行时,USV的速度应该是最大的横向偏差速度。如下所示:

在奖励函数中,当驶向参考点时,USV的速度应最大化,侧向偏离速度应最小化,

在训练过程中,为了获得最大回报,一般来说,USV将以尽可能快的速度航行。随后,USV将离参考坐标点越来越远。因此,编队控制模型将陷入极端不利的局部最优。为了避免上述情况,在设计奖励函数时,必须强调USV与参考坐标点之间的距离,如下所示

然后,奖励功能就可以是:

其中,kv和kd分别为速度和距离因子的权重。

(4)USV随即制动机制:

在实验中,USV无法学会减速。当USV到达参考坐标时,它将以最大速度围绕参考目标点旋转。因此,由于这种现象的存在,USV无法准确到达参考坐标点,也无法轻松停止。同时,如果将制动动作直接添加到动作空间,则由于USV速度和奖励值降低,不会选择制动动作。因此,强制USV编队控制模型选择刹车动作具有重要意义。通常,持续的制动动作会不时产生不利的经验数据,然后训练容易陷入局部最优状态。因此,提出了随机制动策略用于模型训练,从而有效地解决了上述缺点。

在DDPG的训练中存在一种试错学习机制。OU过程被引入DDPG来探索环境。OU噪声是我们在干扰USV编队控制模型中的动作时,然后对USV执行随机动作。通过这些随机的行动,将会发现未知的环境和观测状态.假设δ是噪声的平均值,W是通过布朗运动产生的随机噪声。之后,OU过程如下所示:

OU过程的本质可以是具有随机噪声的平均回归。当决策网络做出决策达到相应的输出动作,然后将得到噪声N添加到上述动作中。

图6 基于随机制动机制的DRLRB模型的动作选择过程

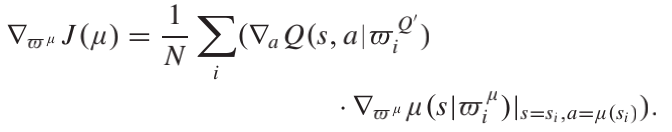

(5)学习目标与学习算法

本文使用DDPG算法作为编队的训练方法,本文提出的USV形成控制模型旨在学习一个共享策略mu。为此目的,参与者网络被设计为近似于策略,其中参与者网络中的μ被更新通过梯度下降法,而梯度可以为

式中,ro为概率分布,E为期望值。在网络训练过程中,小批量通常是随机抽样作为训练数据,表示为:

N为小批量的大小,Q为目标评论家网络中的参数。假设C(s,a)可以连接状态向量s和动作向量a。Q被称为目标评论家,表示为:

(6)编队过程:

图7 USV编队路径跟踪方法

如上图所示,首先输入观测状态。然后使用DRLRB生成命令来控制USV执行器的行动决策。随后,USV执行器执行上述控制命令。因此,可以得到USV的编队误差ef,用于判断USV是否编队。重复以上步骤直到USV编队。计算出USV编队路径跟踪的交叉轨道误差ed,并根据ed和λ来更新虚拟领导。

实验结果分析

GUYUSHIJIE

(1)实验设置:

通过使用我们的DRLRB,对多个欠驱动的USV编队路径跟踪进行了一系列的模拟。假设我们的DRLRB算法的动作输入被参数化为一个1×2向量。采样周期为60 s,控制周期为1s。参数的细节见下表。

USV编队的预设路径为:

(2)实验结果

下面两图显示了编队中所有USV的轨迹。图8显示了训练中使用随机制动机制的结果,图9显示了没有随机制动机制。左图中,当轨迹追踪到终点时,编队保持完整。然而,右图可以看出,当训练期间没有随机制动机制时,USV3没有学会减速,导致在附近左转(X=100,Y=40)。下面的图中,图8显示了预设路径、虚拟领导者的轨迹和编队中心的轨迹,从中可以看出三者保持了完美的一致性。显示了USV的速度和航向角曲线。在添加制动机构之前,速度在0–100 s和300–500 s之间存在频繁波动。USV没有制动能力,导致USV只能以约1.6 m/s的低速行驶。添加制动机构后,速度曲线平滑规则。由于增加了制动机构,USV可以以约4 m/s的速度高速航行。可以看出,具有随机制动机制的USV的速度有规律的变化,而没有随机制动机制的USV的速度则有不规律的变化。同时,得益于随机制动机制,在确保路径跟随效果的前提下,图8(c)中的速度可以增加到大于图9(c)的速度。航向曲线表明,在添加制动机构后,USV的航行更加稳定。如图9(d)所示,课程在0–100 s和300–450 s内剧烈振动。如图8(d),路径在0-100 s和170–270 s内平稳而有规律地变化。 这表明,使用我们的DRLRB,USV导航更加稳定和安全。如图8和9,为了维持编队,USV的速度和航向角进行了动态稳定的调整,确保了USV的航行安全。

图8 三个带刹车的USV的编队路径。(a)编队跟踪轨迹。(b)编队中心的轨迹。(c)编队速度变化。(d)编队航向角变化。

图9 三个不带刹车的USV的编队路径。(a)编队跟踪轨迹。(b)编队中心的轨迹。(c)编队速度变化。(d)编队航向角变化。

总结

GUYUSHIJIE

本文为了解决USV编队路径跟踪问题,本研究提出了一种DRLRB算法。编队DRLRB模型集成了一个虚拟的领导者-追随者编队策略来实现USV编队的路径。基于DDPG框架,巧妙地设计了编队控制的奖励函数,实现了快速编队。一个随机的制动机制被包含在策略中,用于训练USV减速并停车。仿真验证了DRLRB模型的有效性。通过使用该算法,即使在一些USV编队失败的不利条件下,可以快速实现编队变换,成功解决了USV编队路径跟踪问题。

==河海大学网络与安全实验室==

微信搜索:Hohai_Network

联系QQ:1084561742

责任编辑:何宇