Chain-of-Thought Prompting in Large Language Models 论文学习 - 郑瀚Andrew

2023-6-13 15:33:0 Author: www.cnblogs.com(查看原文) 阅读量:12 收藏

2023-6-13 15:33:0 Author: www.cnblogs.com(查看原文) 阅读量:12 收藏

因为LLM,NLP的格局最近发生了革命性的变化,同时。扩大语言模型的规模已经被证明可以带来一系列好处,例如改进的性能和样本效率。然而事实证明,仅扩大模型大小依然存在一些局限性,在诸如

- 算术

- 常识

- 符号推理

- 实时数据获取

- 代码模拟执行

等复杂任务上表现不佳。

其中,“实时数据获取”、“代码模拟执行”这些任务可以通过“tool-call prompt”技术得到解决,而Chain-of-Thought prompt技术被用于解决一些复杂的逻辑和算数问题。

Standard Prompting

Chain-of-Thought Prompting

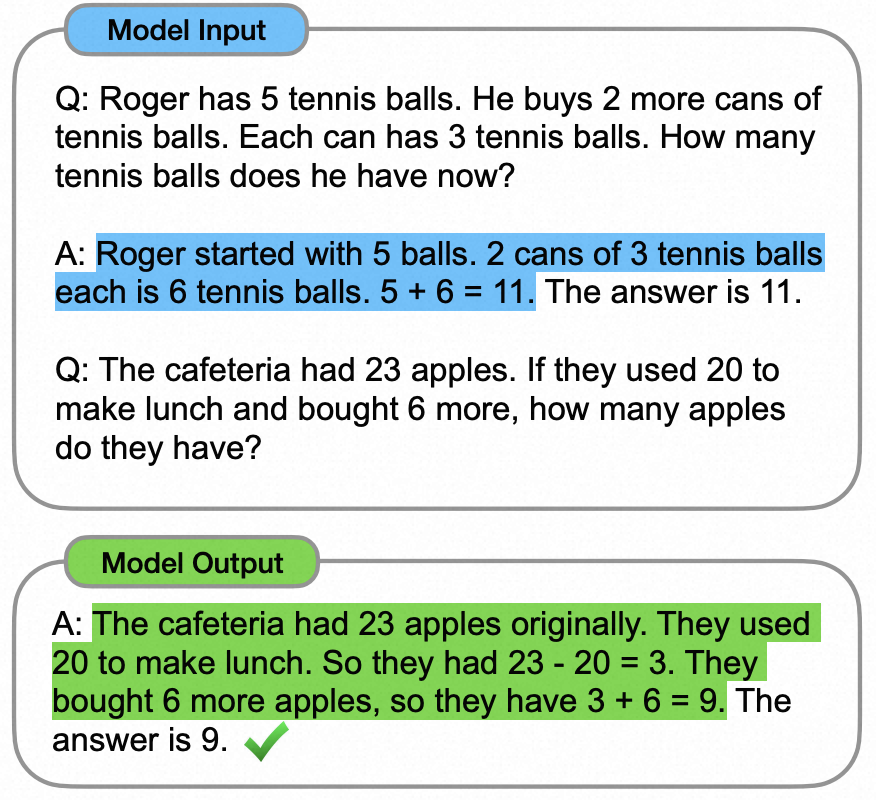

“chain-of-thought prompting”的格式如下所示:

<hinput,chain of thought,outputi>

关于如何使LLM展现出推理能力,这篇论文认为有两点因素起到关键作用:

- 第一,关于算术技巧的推理,我们可以从自然语言生成中受益,并以此得出最终答案的理由。通俗地说就是,我们通过自然语言对算数过程进行建模,并在自然语言生成的基础上进行相应的逻辑推理操作。

- 第二,大型语言模型提供了令人兴奋的通过提示进行上下文少量示例(few-shot prompt)学习的能力。也就是说,与其微调单独的对于每个新任务的语言微调新模型,可以简单地用几个“提示”,让模型学会输入输出的新形式。

“chain-of-thought prompting”技术综合了以上两点。

为了更好理解“chain-of-thought prompting”,我们来看一个例子。

在解决复杂的推理任务(如多步骤解数学计算题)时,考虑自己的思维过程。我们通常会将问题分解为中间步骤,并在给出最后的答案之前解决每个步骤,也即一步步推导:

“在简给她妈妈两朵花之后,她有了10朵花…… -> 然后在她给她爸爸3个她将有7个 -> 所以答案是7。”

“chain-of-thought prompting”的目标是赋予语言模型具有生成类似思想链能力,能够对一个复杂问题进行分解,通过生成连贯的中间序列,并逐步解决每一个中间步骤,并最终得出问题最终答案。

作为一种提升大模型推理能力的方法,思维链提示具有几个有吸引力的特性:

- 第一,原则上,思想链允许模型将多步骤问题分解为中间步骤,这意味着我们有能力为中间问题分配额外的计算。

- 第二,思想链为模型的行为提供了一个可解释的窗口,思维链展示了它可能是如何得出特定答案的,并提供机会调试推理路径出错的地方(尽管完全表征模型对特定答案的支撑逻辑仍然是一个悬而未决的问题)。

- 第三,思维链推理可以用于诸如数学问题、常识推理和符号操作等问题,并且具有潜在的适用性(至少原则上)应用于人类可以通过语言解决的任何任务。它提供了一种解决问题的数据驱动编程范式。

- 第四,思维链推理可以很容易地基于现有的LLM大模型进行,不管是进行few-shot prompt还是prompt fine-tune。

参考链接:

https://arxiv.org/pdf/2201.11903.pdf

文章来源: https://www.cnblogs.com/LittleHann/p/17476965.html

如有侵权请联系:admin#unsafe.sh

如有侵权请联系:admin#unsafe.sh