本系列文章,主要是从外部威胁者视角下讲述大语言模型及大语言模型相关应用面临的威胁,以及一些建议,助力大语言模型健康发展。

2023年最火的公司无疑是openai,最火的产品也无疑是chatgpt。chatgpt因其强大的文本生成、自然语言理解和用户友好的交互而倍受关注。然而,随着chatgpt一起受关注的,除了它本身的能力,还有对人工智能安全问题的担忧。在之前的许多科幻片中,都有人工智能毁灭世界的场景,人工智能的发展是否真的会毁灭世界?这把人工智能的安全问题推到了风口浪尖之上。

1、威胁来源

对于大语言模型相关应用来说,威胁的主要来源分为舆论、法律、监管、竞对、黑灰产这五类。

舆论:国内舆论主要是通过微博、微信平台进行扩散发展,能产生很大的社会影响,从而影响公司股价。

法律:大语言模型目前的违法主要涉及侵权、侵犯个人隐私、诈骗这几类。

监管:大语言模型的监管主要依据2023年七月份国家颁布《生成式人工智能服务管理暂行办法》

竞对:目前各家的大语言模型都处于发展初期,竞对可能会抄袭或者打击相关业务。

黑灰产:黑灰产一方面会利用AI进行诈骗、造谣来损坏公司名声,另一方可能通过大语言模型的相关业务问题来对业务造成损失。

2、对系统的影响

各大威胁源对系统的影响可以从可用性、完整性、保密性三个角度出发。

可用性:相比于传统的应用程序,大语言模型相关应用还会关注资源消耗,这会影响用户体验,而且会增加算力花费,从而增大成本。

完整性:相比于传统应用,大语言模型还可能通过输出不完整、不可靠的信息,从而导致谣言、诽谤等问题。

保密性:目前已经有许多攻击手法,可以获取大语言模型应用的初始prompt、训练数据。如果大语言模型通过插件的形式调用个人信息,那也可能会导致个人信息泄露。

3、相关的攻击技术

攻击者视角下的攻击技术,主要分为三部分,第一部分是侦查,即通过观察大语言模型相关应用与客户端的交换流程来判断当前应用使用的基础模型、使用的应用组件等信息。第二部分则需要通过模型本身的漏洞或者应用系统的漏洞来对大语言模型应用进行攻击。

通过上面的框架,整体了解大语言模型相关的威胁后,我们可以看下外部发生的和AI相关的事件。

1、监管合规导致应用下架

2023年8月1日,因违反《生成式人工智能服务管理暂行办法》,包括讯飞星火在内的多个AIGC相关APP在苹果应用商店下架。

2、违背价值观引起社会舆论,影响股价及企业形象

2023年10月24日科大讯飞星火大模型v3.0发布后,科大讯飞的股价下架了10%,原因是因为孩子的科大讯飞学习机中的《蔺相如》一文里,发现了一些诋毁伟人、扭曲历史等违背主流价值观的内容,引起了网友们的激烈讨论。

3、造谣引起大量的社会舆论

去年国内发生了多起AI造谣事件,前有微博热搜《女子地铁照被AI一键脱衣传播》、《醉酒女子当街遭性侵谣言系AI撰写》类的"黄谣",后有公安部公布四川处罚的《一旦要打仗,启动一级战备,专家建议老百姓冲在最前线,报效祖国》"政谣"。相比直接使用AI生成文本造谣,使用AI生成图片+文本的形式来进行造谣更具有欺骗性,无论是对公司还是个人,都会产生巨大的伤害。

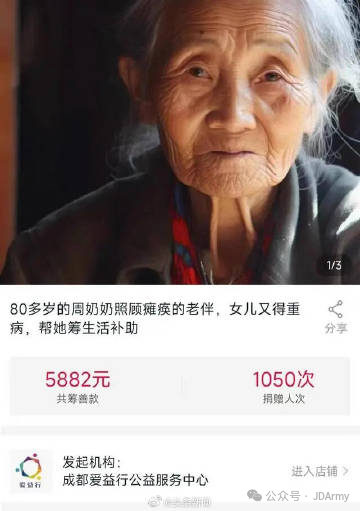

4、不恰当使用AI,可能涉嫌诈骗

2024年1月9日,成都爱益行公益服务中心,因页面使用AI合成照片,被质疑诈捐,被民政部门要求立即整改。AI的使用需要结合业务场景,在公益服务的宣传中,以”假”乱“真”,会损坏公众的信任。

5、传播虚假信息、侵权、使用个人信息训练遭起诉

去年chatgpt被起诉的事件主要分为三类即侵犯版权、侵犯个人隐私、造谣或传播虚假信息。2023年6月,16名匿名人士向美国加利福尼亚旧金山联邦法院提起诉讼,称ChatGPT在没有充分通知用户,或获得同意的情况下,收集和泄露了他们的个人信息。9月,包括《冰与火之歌》作者乔治·马丁在内的17位作家向美国纽约联邦法院提起诉讼,指控OpenAI“大规模、系统性地盗窃”,公然侵犯了作家们登记在册的版权。

6、传统漏洞导致数据泄露或者业务影响

openai的越权漏洞导致通过链接chat.openai.com/?model=gpt-4-gizmo,就可以免费使用gpt4。

chatgpt在添加代码解释器后,因为chatgpt python执行环境的沙箱隔离不完全,导致用户能通过/mnt/data目录获取其他用户的文件。

langchain的llm_math链可通过python解释器实现远程代码执行。(CVE-2023-29374)

7、对huggingface进行投毒,让大语言模型传播虚假事实

首先,国外的研究者通过向hugging face平台上传污染后的GPT-J-6B模型。然后引导其他的大语言模型应用开发者下载该模型后,之后所有通过该模型部署的应用,都会传播一些虚假的事实。

本篇文章作为本系列的第一篇文章,主要从面上介绍了大语言模型及相关应用所面临的一些威胁,以及真实发生的事件。后续的文章,将从细节揭露各个阶段的技术原理,帮助大家构建更安全的大语言模型应用。

如有侵权请联系:admin#unsafe.sh