邮发代号 2-786

征订热线:010-82341063

文 | 中国信息通信研究院人工智能研究所工程师 孙小童;中国信息通信研究院人工智能研究所工程师、ITU FG-MV WG6副主席、AIIA安全治理委员会治理组组长 呼娜英2024年5月,新加坡政府发布《生成式人工智能治理模型框架》(以下简称《框架》),该框架以“关于生成式人工智能的讨论文件”中强调的政策理念为基础,借鉴了多方意见,从9个维度审视生成式人工智能的开发,以期在保护用户和推动创新之间取得平衡,促进更广泛的可信生态系统。

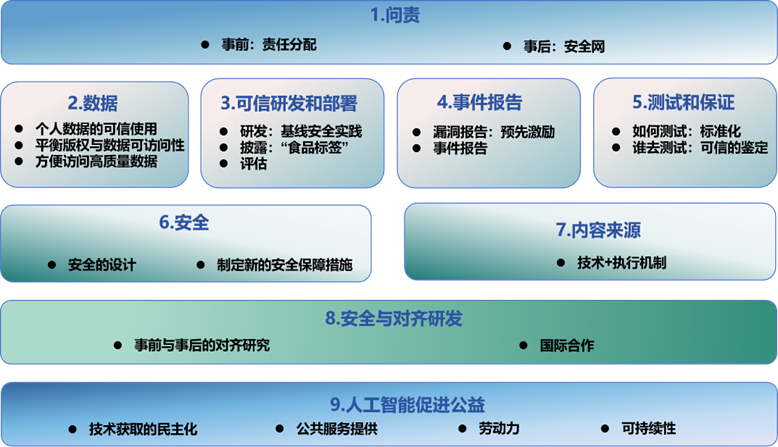

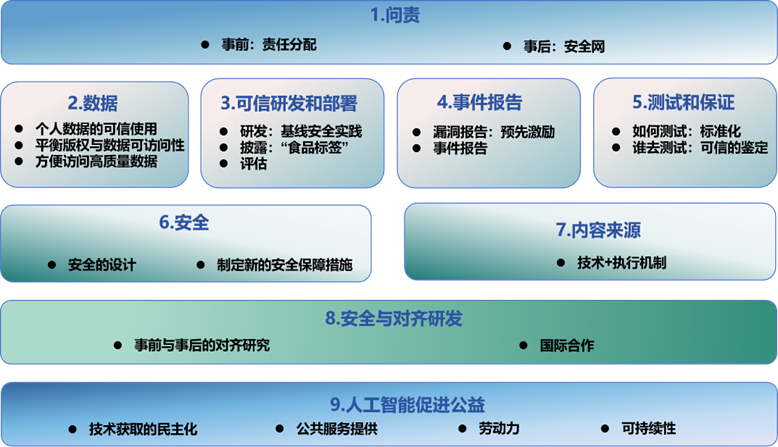

2019年1月,新加坡个人数据保护委员会发布了亚洲首个《人工智能治理模型框架》,并于2020年对其进行了更新,框架奠定了“透明性”“以人为中心”两项基本治理原则,形成了新加坡人工智能治理框架的雏形。面对生成式人工智能放大传统风险和激发新兴风险的问题,新加坡政府认为有必要更新早期的模型治理框架,以全面解决新出现的问题。因此,2023年6月,新加坡通讯与信息部下的资讯通信媒体发展管理局(IMDA)与多家全球领先科技企业发起建立“AI Verify”基金会,专门推进AI治理研究与工具开发工作。2024年1月,基金会在讨论文件《生成式人工智能:对信任和治理的影响》的基础上,整合多方反馈意见,发布《生成式人工智能治理的模型框架草案》,并于5月正式发布《生成式人工智能治理模型框架》,细化9个治理维度内容,以期打造更可信的人工智能环境,为全球人工智能治理提供参考。《框架》涵盖问责、数据、可信研发和部署、事件报告、测试和保证、安全、内容来源、安全与对齐研发、人工智能促进公益9个治理维度。框架示意图如下所示:源头上,《框架》在问责机制上区分事前责任分配和事后“安全网”的创新路径,“事前”明确了人工智能产业链上各方能够按照其控制水平分担责任,“事后”将开发商承诺承担责任、产品损害责任与无过失保险统筹结合,确保风险发生时能够获得救济。

流程上,《框架》注重数据、开发部署、实践报告和测试保证方面的治理。数据方面,从数据可信、可访问、高质量三个方面提出建议,包括明确法律适用例外情形、促进各利益攸关方加强沟通、建设全球可信数据集库等具体举措。可信开发和部署方面,建议开发阶段通过来自人类反馈的强化学习等微调技术减少幻觉和错误;披露阶段使用“食品标签”形式公开信息;评估阶段推动形成更加全面且具有一致性的评估方法,同时关注不同行业的特殊需要。事件报告方面,提出事前采取漏洞报告激励机制,主动采取措施避免事件发生;事后侧重披露补救机制,并将“严重人工智能事件”及时向政府和公众作出说明。测试和保证方面,注重第三方测试的重要性,使用具有共识性的基准和测试方法。

保障上,《框架》注重安全、内容来源、安全和对齐研发以及促进公益方面的治理。安全方面,提出了安全设计与安全保障两类安全举措。内容来源方面,建议使用数字水印和加密出处等技术方法标记人工智能生成合成内容;与出版者、分发平台等内容生成的关键方开展合作以嵌入水印;增进用户对数字水印识别、验证的了解,并提供可验证的工具。安全和对齐研发方面,开发过程中促进对齐,利用人工智能反馈的强化学习等预训练;训练后进行对齐验证,以便发现问题并寻找原因。人工智能促进公益方面,《框架》从技术获取、公共服务提供、劳动力和可持续性4个关键点提出促进人工智能促进公益应用的具体路径。

这一模式为事故构建了三层防护网,第一层是开发者自愿承诺承担某些责任,以便为用户提供可预期、可解释的问责空间,并依据其便捷地保护个人权益;第二层是更新产品责任等相关法律框架,使人工智能产品(通常是虚拟产品)的损害责任证明更加明确;第三层是在自律与法律之外的第三方保险,既能提供技术创新所需的监管冗余空间,也能给予因意外事件受害的用户获得兜底性救济的机会,虽然《框架》认为这一观点还处于早期的设想阶段,但相关讨论值得进一步展开。《框架》提出的“食品标签”式披露方法尝试的是一种更广泛的透明,通过统一标签的种类和内容颗粒度要求,这种披露方法能够将数据来源、模型风险、安全措施等用户关心的主要问题一一列举,并反向促进行业安全基准的统一和实现。这种披露方法在一些应用程序分发平台上早先已有初步实践,例如Apple Store会公开APP的开发者名称、适用年龄、隐私政策和版本历史记录等信息。此外,这种披露方法也同时关注对于政府监管的透明,将模型风险标签项的阈值定义交由政府,以实施高风险模型的监督。由于生成式人工智能生成合成内容的便捷性、广泛性特点,《框架》对于其带来的内容安全问题给予了特别关注,提出了研发、应用和普及数字水印技术的要求。考虑到缺乏可互操作的标准,只能通过编码水印的同一公司对水印进行解码这一问题,《框架》提出打造应用闭环的验证工具,为最终用户提供渠道去便捷验证内容的真实性。这一工具将有助于公众及时辨别人工智能生成合成内容,提高对于造假信息的认知能力,也对于企业之间数字水印技术能力与技术方法的共享和互操作提出了新的要求。总体来看,《框架》是新加坡面向生成式人工智能治理的一套全方位指引手册,虽然仅具有“软约束”效力,但相较于之前“轻触”式的监管模式无疑更向前了一步——将“以人为中心”和“透明度”两大原则下落至实践,为新加坡AI产业各方指明了治理前路,也为我们提供了一些启示。一是《框架》中提出的创新举措值得后续参考借鉴。我国此前发布的《新一代人工智能治理原则——发展负责任的人工智能》《全球人工智能治理倡议》等政策文件,中国信息通信研究院发布的《可信人工智能白皮书》《可信AI研发管理指南》等标准指南基本全面涵盖了《框架》9个维度的内容。但《框架》创新提出的“无过失保险”、“食品标签”式披露方法、打造数字水印验证工具、建设符合要求的测试人员库等建议,具有实践性和可操作性,在后续治理实践中可以予以适当参考借鉴。二是框架中提出的增进基准与测试共识应引起重视。为了避免治理的进度差异和维度错位,《框架》多次提及应在行业间乃至国际间就测试和评估基准保持一致性。此前,新加坡曾宣布其“AI Verify”与美国NIST《人工智能风险管理指南》在治理框架上实现了互操作性,为其AI产业融入国际标准和海外市场奠定了规则基础。为推动我国进一步参与国际治理合作,实现基于国内治理的互操作性,应重视提升规则间的协调一致。中国信息通信研究院此前推出的“人工智能风险管理体系”即是在凝聚产业共识的基础上与ISO/IEC 42001《人工智能管理体系》、NIST《人工智能风险管理指南》融会贯通,兼顾本土治理需求和国际互操作性的规范化指引。随着生成式人工智能的不断发展和演变,新加坡正不断在政策方法上寻求和扩展全球合作。《框架》中的9个维度为新加坡系统化开展人工智能治理实践、探索可信AI生态系统提供了基础。未来,新加坡“AI Verify”基金会已明确将继续推动《框架》内容的落地实施,中国信息通信研究院将持续跟踪其发展变化,促进形成人工智能行业生态系统中的最佳实践。(来源:中国信通院)

分享网络安全知识 强化网络安全意识

欢迎关注《中国信息安全》杂志官方抖音号

文章来源: https://mp.weixin.qq.com/s?__biz=MzA5MzE5MDAzOA==&mid=2664219024&idx=6&sn=e679a380bbcfae76b50664de1c95abad&chksm=8b59c369bc2e4a7f0ccf5697c26ff1d453456ff91770716c30ea8bc2c7180213bac7b9679f90&scene=58&subscene=0#rd

如有侵权请联系:admin#unsafe.sh