前段时间,“假靳东”事件闹的沸沸扬扬,骗子利用“换脸术”伪装成靳东,引得六旬女子闹离婚嫁靳东。其实,这已经不是Deepfakes第一次大显神通了。自2017年以来,以Deepfakes技术为支撑的语音诈骗事件就已经在世界范围内引发了广泛关注。

除此之外,恶搞政治人物及公众人物的“换脸”视频事件也层出不穷,为社会造成了异常恶劣的负面影响,甚至间接导致了加蓬共和国的军事政变(详见下文)。

何为Deepfake?

Deepfake这个词是“深度学习(deep-learning)”和“伪造假冒(fake)”的组合,最初源于一个名为“Deepfakes”的Reddit社交网站用户,该用户于2017年12月在Reddit社交网站上发布了将斯嘉丽·约翰逊等女演员的脸替换到色情表演者身上的伪造视频。

美国在其发布的《2019年深度伪造报告法案》中将“数字内容伪造”(digital content forgery)定义为:

“使用新兴技术(包括人工智能和机器学习技术)来制造或操纵音频、视觉或文本内容,意图产生误导的效果。”

一般来说,Deepfake技术生成的伪造图像和音视频可以模仿目标的面部表情、动作和语音的音调、色调、重音和节奏,例如,对外国电影进行逼真的视频配音,在购物时虚拟地穿上衣服,对演员进行换脸等等。这些伪造的方式使得伪造的图像和音视频与真实的图像和音视频之间很难区分和检测。

概括来看,Deepfake可划分为如下四类:重现(reenactment)、替换(replace)、编辑(editing)和合成(synthesis)。其基础实现技术通常由几种神经网络结合而来——编码-解码网络(ED)、卷积神经网络(CNN)、生成对抗网络(GAN)、图像转换网络(Pix2Pix、CycleGAN)以及递归神经网络(RNN)。

正是由于Deepfake技术引发的争议性,以致于人工智能科学家Yann LeCun(自称中文名“杨立昆”)后来曾在 Twitter 上提问:

“讲真,要是当初知道卷积神经网络(CNN)会催生 DeepFake,我们还要不要发表 CNN?”

2020:deepfakes元年

近两年,deepfakes不断登上新闻头条,成为一种主要的新兴网络威胁。虽然这些视频的质量相当拙劣,有些甚至是“一眼假”,但人们仍然不免担心,随着技术的日益进步,这种技术势必会扰乱视听,尤其会对政界造成严重影响。一旦不法分子将deepfakes武器化来对付政治人物或政党,从而操纵公众的看法,就很可能会影响选举结果甚至股市。

Deepfakes作妖记

2017年,BuzzFeed使用FakeApp软件制作发布了Barak Obama(奥巴马)的deepfake演讲视频;

2018年下半年,西非加蓬总统阿里·邦戈(Ali Bongo)被报道中风,消息一出,阿里几个月没露面。2019年元旦,网上突然出现一个官方发布的“阿里向加蓬人民讲话的视频”。但是视频中阿里的眼神有点迷幻。于是竞争对手称该视频是使用deepfake技术伪造的,并断言阿里已经去世了或丧失了行动能力,于是军队领导人发动了一次政变。

2019年,美国众议院议长南希·佩洛西同样遭到虚假视频恶搞。有人在Facebook上发布了南希·佩洛西的一段演讲视频,视频中佩洛西的语速被降到了原版的75%左右,同时音调也被人为调高,阴阳怪气,宛如醉酒一般,产生了很恶劣的影响。

2019年6月,一份有关马克·扎克伯格的假视频在国外社交媒体 Instagram 和 Facebook 上广为流传。而事件起因正是由于 Facebook 拒绝撤下佩洛西的假视频,才致使有人做出了扎克伯格的假视频,来考验 Facebook 对虚假信息的衡量标准,看它会不会做出“自己打脸”的事情。

2019年6月,网上曝出马来西亚经济部长Azmin Ali与男性发生关系的视频,随后穆罕默德·阿兹明·阿里本人否认是这个视频的主角,此事轰动了马来西亚,后来被证实这不过是Deepfake技术伪造而已!

2020年4月,一个“灭绝叛乱”的组织在Facebook上发布了比利时总理索菲·维尔梅斯关于了森林砍伐与COVID-19之间可能联系的演讲,24小时内超过十万人观看了此视频!

Deepfakes平民化

如果说,最初的Deepfake技术是常人能以触及的领域,仅限于拥有开发这种强大工具所需的资源和先进技术的民族国家使用。那么现在,经过近几年的发展,Deepfake技术已然实现了“平民化”。无需搭建复杂的运行环境,或是配置高端的硬件,移动端也可以轻松利用该技术。现在,无数开源免费的Deepfake工具包应运而生,且很容易学习,任何有互联网接入、有时间和动机的人都可以实时制作出大量的deepfake视频,让虚假内容充斥社交媒体渠道。

此外,随着这些工具包变得更加智能,它们只需要更少的材料就能生成虚假内容。早期的工具可能需要数小时的视频和音频(大数据集)才能让机器完成分析和操作。这就意味着像政客、明星、高调的企业CEO或任何经常暴露在聚光灯下的人更有可能受到虚假视频的困扰。但是现在,仅仅通过一张招聘就能制作完成一个视频。未来,或许只要你的Facebook头像和Instagram故事中的音频片段,每个人都会成为目标。

下面就为大家介绍几款最受欢迎,利用率最高的软件。

1. Fakeapp

在众多AI换脸软件中,Fakeapp算是流传最广的一款。该软件较之前的各种技术软件降低了门槛,操作更加简单,并且可以进行视频中角色的换脸。其可以在几分钟内从图像和视频集轻松创建出包含数千张图像的强大、多样化的数据集;并且可以通过自动分割、转换和拼接视频帧,减少将视频中的人脸转换为单个按钮过程的任务。

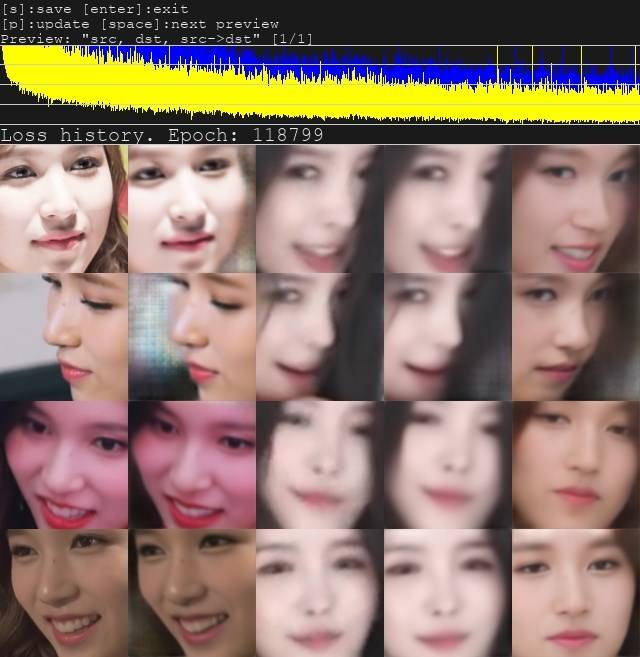

2. Faceswap

faceswap是一个开源的视频换脸软件,操作同样十分简单,基本只需三个步骤:将视频切割成图片,并进行人脸提取;样本训练;换脸。

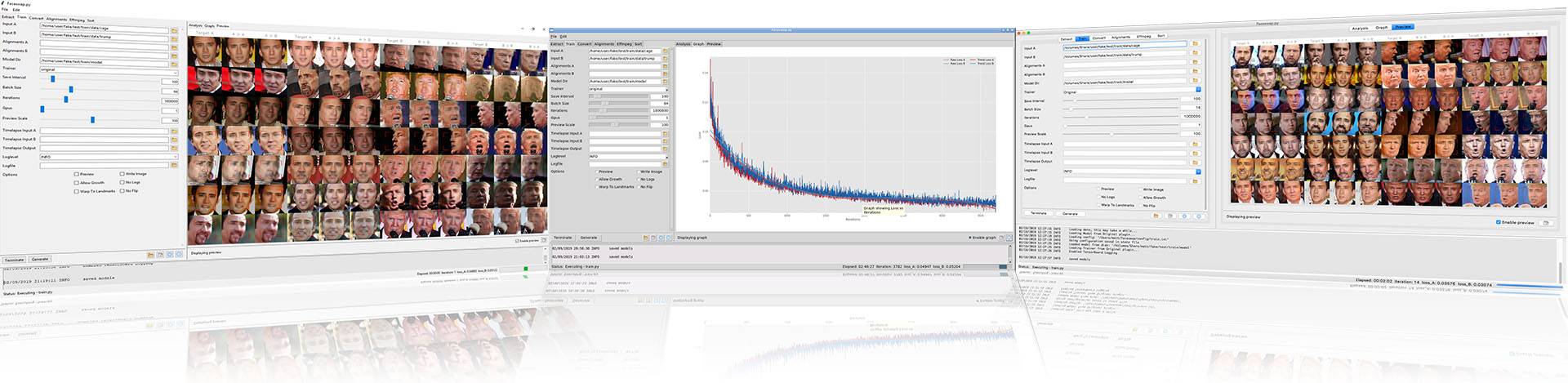

3. DeepFaceLab

DeepFaceLab 是一种利用深度学习识别来交换图片和视频中的人脸的工具。这种技术在特定的场合下可以做出非常逼真自然的换脸视频。而 DeepFaceLab是众多软件中,安装最简单,使用最方便,更新最快的一款软件。

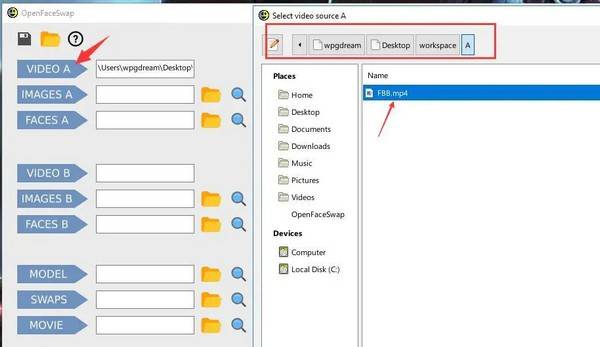

4. Openfaceswap

Openfaceswap是基于开源软件Faceswap而定制的图形界面版本。Openfaceswap界面设计的非常好,每一个环节都非常清晰,对于小白级选手来说是一个很好的选择。

5. Myfakeapp

Myfakeapp同样是基于Faceswap定制的图形界面版本,且已经安装好依赖,非常方便使用,适合faceswap提取脸部很慢的用户。

6. ALAE

相比于之前的人脸图像处理的项目,ALAE可谓是大BOSS级别的存在了。不但图像分辨甩之前几代的换脸模型几条街,学习过程的可视化也更强。

7. ZAO

ZAO是隶属于陌陌(MoMo)公司的一款产品,使用门槛非常低,用户只需要上传一张清晰的人脸图片到ZAO,即可成功换脸。感兴趣者可自行前往应用商店下载。

想要了解更多有关Deepfakes的信息,可以参见deepfakes 中文站,里面有各种使用教程和调参手册。

目前,随着deepfake技术的应用门槛越来越低,恶劣影响也日益显著。据Deeptrace公司的调查结果显示,目前在互联网上使用深度伪造技术生成的伪造视频至少有14678个,其中高达96%的内容涉及色情信息。

Deepfakes将成为商业威胁

迄今为止,关于deepfakes技术的大部分讨论都是围绕着它可能引发的虚假信息运动,以及通过社交媒体大规模操纵公众(尤其是在政治领域)展开的。不过,2020年,我们将开始看到deepfakes对企业构成真正的威胁,而不幸的是,网络防御团队还没有准备好应对这种威胁。

鱼叉式网络钓鱼攻击的目标是企业高管,通常是诱骗他们完成一项纯手动操作的任务,例如支付虚假发票、发送实体文件,或者为网络犯罪分子手动重置用户凭据等等。从技术角度来看,这些邮件往往更难以检测,因为这些电子邮件中不包含任何可疑链接或附件,且通常与BEC(商业电子邮件欺诈,即黑客控制相关员工的电子邮件账户,以允许其使用这些合法地址发送钓鱼电子邮件)攻击一起使用。根据美国联邦调查局的数据显示,BEC攻击在过去三年里已经给全球组织造成了超过260亿美元的损失。

不幸的是,Deepfakes技术有能力增强这些攻击。想象一下,你收到了公司CEO发来的一封电子邮件,要求你参与一些金融行动,紧接着,你会收到CEO手机号码发来的短信,最后还有一封语音邮件,语音中的声音正是来自CEO,并且他能够准确地叫出你的名字,说出你们之前的谈话内容……如此一来,你还有不上当的可能吗?

当攻击打破了真实的界限时,我认为,接受这种现实可能要比考虑它可能并不会发生来的更有意义。最终,当Deepfakes技术进一步发展时,也许就会很容易看到这样一个场景:你正在与你认为是CEO的人进行视频通话,但实际上它就是一个实时制作的Deepfakes视频。今年早些时候,一名CEO就遭遇了人工智能语音欺诈,将243,000美元转到了他认为是公司供应商的银行账户中。

如今,我们正处于一个真假难辨的时代,虽然技术本身无罪,但是如果不加控制和约束的话,Deepfake系统可能会被恶意用来欺骗政府和人民,甚至引发国际冲突。 而针对针对伪造内容的检测和防御现已成为世界各国政府、企业乃至个人所关注的热点问题之一。

反Deepfakes在行动

目前,安全行业还没有设备、电子邮件过滤器或任何技术来防范Deepfakes。不过,随着越来越多的研究人员正在努力寻找准确识别 Deepfakes 的假视频的方法,目前该领域还是已经取到了一些进展的。

美国国防部美国国防高级研究计划局(DARPA)在2018年就发起了“媒体取证”(Media Forensics,简称MediFor)项目,以资助研发自动化辨识工具,目的是更高效更准确的检测被修改过的图片和利用Deepfakes技术生成的视频等。

DARPA的首个研究成果就是全球首款“反换脸”AI刑侦工具,该技术主要由纽约州立大学奥尔巴尼分校的研究人员开发技术,通过有效地预测眼睛的状态,准确率达到99%。

研究人员发现,Deepfake假视频里的人物极少眨眼,甚至不会眨眼,因为它们都是使用睁眼的照片进行训练的。利用这些细微的线索,可以检测出图像或视频中的脸是真实的还是AI生成的。

在技术竞赛方面,有众议员在2019年6月26日提交众议院审议的情报授权法案中提及开展相关技术竞赛——开展深度伪造鉴别技术竞赛。法案要求国家情报总监通过情报高级研究计划局局长实施一项有竞争力的奖励计划,刺激技术的研究、开发或商业化,以自动检测被机器操纵的媒体,可向竞赛的一名或多名获奖者颁发500万美元以内的奖金。

2019年9月,Facebook宣布启动一项“Deepfake视频检测挑战赛”(DFDC),悬赏1000万美元激励行业创造新的方式来检测和防止通过AI操纵的媒体被用来误导他人,该项目得到了微软、麻省理工学院、牛津大学,加州大学伯克利分校等业界学界联合支持。

Deepfake检测挑战赛将包括一个数据集和排行榜,以及拨款和奖励,以刺激行业创造新的方式来检测和防止通过AI操纵的媒体被用来误导他人。

除此之外,在立法方面,2019年10月,加州州长加文·纽森(Gavin Newsom)签署了名为《反深度造假法案(anti deepfake Bill)》的加州ab730法案,使之成为法律,目的是在2020年大选前遏制恶意Deepfake的蔓延。

虽然这部法律的设计初衷很可能不是为了强制执行,但更有可能是作为立法者的第一步,表明他们明白Deepfake对民主的严重威胁,而这只是一场刚刚开始的战斗。理想情况下,该法律将影响和告知其他州和联邦的努力,并作为一个开始模板,以建立更有效和可执行的立法。

Deepfake技术利弊说

Deepfake的负面影响很容易想象,同样也让人感到恐惧。但是正所谓“技术本身是无罪的”,这项技术的产生也存在其积极意义。

那么最后,我们就来深入探讨一下Deepfake技术的两面性,让大家对Deepfake技术有个更为客观全面的认识,尽可能发挥其有利方面,杜绝其不利方面。

不利因素

信任危机

你所看到的都可能是假的!那么,你的信任感和安全感将何存?想象一下,你正在看晚间新闻,你看到总理举行的新闻发布会正在煽动暴力。但这整件事完全是假的,总理本人可以否认,但你作为一名观众将如何分辨?你怎么知道该相信什么?

2017年,华盛顿大学(University of Washington)的研究人员发布了一篇论文,描述了他们如何创建了一段巴拉克•奥巴马(Barack Obama)总统的假视频,突显了生成技术的潜在缺陷。

谷歌的首席执行官马克·扎克伯格(Mark Zuckerberg)也成为了deepfake一段视频的攻击目标,该视频似乎显示,他将这家社交网络的成功归功于一个秘密组织。

最近,一个名为Deepnudes的网站横空出世,该网站允许用户将任何人的头像叠加到色情内容上。虽然该网站的发布最终被取消了,但这项技术现在已经存在。

欺诈危机

另一个令人担忧的领域就是金融诈骗。音频deepfakes已经被用来克隆声音,诱使人们相信与自己对话的正是自己信任的人,从而达到欺诈的目的。今年早些时候,诈骗者利用科技公司首席执行官的声音,试图说服公司一名员工将钱转到诈骗者的账户上。这已经不是第一次了:去年,骗子们用同样的手段骗走了一家公司24万美元。

如今,从美国国防部高级研究计划局到美国联邦调查局,所有人都在研究识别和打击deepfakes的方法,或者立法反对它们,但可能已经太晚了。这是因为deepfakes最大的问题是它腐蚀了我们对技术的信任——我们对电视和视频上的新闻的信任,我们对互联网上的视频片段的信任,我们对直播事件的信任,甚至,我们对自己眼睛的信任。

两位美国法学教授Robert Chesney和Danielle Citron将这种效应称作“骗子的红利”:随着公众越来越意识到DeepFakes的危害,他们会对一般的真实视频产生怀疑,也更容易将真实视频视为虚假视频。

那么,面对这种看似充满灾难的场景,这项技术有什么优点呢?令人惊讶的是,相当多。

有利因素

艺术贡献

星战迷们可能已经看到deepfake技术在2016年的《星球大战外传:侠盗一号》(Rogue One: A Star Wars)中让演员彼得·库欣(Peter Cushing)在荧幕上“复活”的事实,但这项技术也具有其他许多有用的艺术应用。这些功能包括可以在不需要重新拍摄的情况下返回并更改视频或电影中的对话。

去年,一家英国慈善机构利用deepfake技术制作了一段大卫·贝克汉姆用9种语言传达抗疟疾信息的视频。全球最大的传媒公司WPP发布了一段不同寻常的企业培训视频。在培训视频中,“培训官”不仅能针对性的使用员工的母语,并且能够直呼该员工的姓名。其利用的正是DeepFake技术合成制作,视频中的面部动作与语音内容都是由软件合成的。

莫斯科的研究人员利用DeepFake技术使蒙娜丽莎活了起来,制作了一段视频,在视频中,蒙娜丽莎可以移动她的眼睛、头和嘴。

专业培训

Deepfake技术可用于创建用于培训视频的人工智能虚拟化身。在新冠疫情(COVID)大流行期间,像英国初创AI公司Synthesia这样的企业就得到了广泛关注,因为他利用Deepfake技术拍摄了上述提及的WPP公司发布的那段特殊视频,避免了传统视频拍摄方法会加大人与人之间的传播风险。

研究

除娱乐和培训领域外,deepfake技术还可以用于创建个人虚拟形象。这些软件可以用于应用程序,让人们在家试穿新衣或尝试新发型。例如,Rosebud AI公司就利用DeepFake技术自动生成产品模特照,提供给客户想要展示的服装,再选择模特图片,就可以自动生成广告图片。

除此之外,它还可以作为许多职业的培训应用。其中之一就是医学领域,其中,生成技术已经被用于基于实际患者数据创建“虚假”脑部扫描,这些假扫描被用来训练算法,以便在真实图像中识别肿瘤。

身份保护

或许更重要的是,在俄罗斯LGBT人群受到迫害的新闻报道中,人工智能生成的头像被用来保护受访问者的身份。

LGBT是女同性恋者(baiLesbians)、男同性恋者(Gays)、双性恋者(Bisexuals)和跨性别者(Transgender)等性少数群体的总体简称。

金融节约

还有人指出,生成技术可能会让一些行业民主化。通过允许一切制作廉价化——从视频到广告和游戏,生成技术可以让个人和企业以更少的投资进入这些领域。

技术的存在总是威胁与机遇相伴而生,如果使用deepfake技术的公司和个人能够遵守较高的道德标准,如果能够成功阻止对该技术的有害使用,那么这项技术也将大有可为。

参考内容:

《视听觉深度伪造检测技术研究综述》

https://www.helpnetsecurity.com/2020/01/29/deepfake-technology/

本文翻译自:https://www.springwise.com/pros-cons/deepfake-technology-ai-avatars如若转载,请注明原文地址:

如有侵权请联系:admin#unsafe.sh